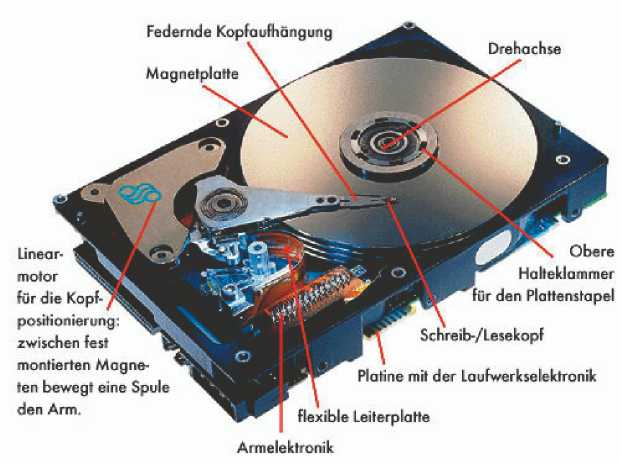

DATENRETTUNG > FESTPLATTEN > Bauteile

Gehäuse: das Gehäuse schützt die mechanischen Komponenten des Computers vor Staub, Feuchtigkeit, usw.

Lese-/Schreibköpfe: sind einer der empfindlichsten Bestandteile der Festplatte, die ständig in Bewegung sind und dadurch ist die Wahrscheinlichkeit, daß Probleme auftauchen größer... und daher der Bedarf an Festplatten recovery

Die Lese-/Schreibköpfe bestehen aus unterschiedlichen Bestandteilen:

Voice Coil : Spulen (1)

Verstärker (2)

Flextor head assembly (3)

Lese-/ Schreibköpfe (4)

E-Block (5)

Die Schreib-/Leseköpfe befinden sich jeweils auf der Ober- und Unterseite der Scheiben. Die einzelnen Köpfe können sich nicht individuell bewegen, sondern sie müssen als ganzes Gebilde agieren. Die Schreib-/ Leseköpfe bewegen sich über die Platten bzw. Scheiben, um Information auszulesen oder zu speichern. Die Bewegung der Lese-/Schreibköpfe erfolgt durch die Bestromung der Spule, die an der Hinterseite des Armes angebracht ist. Wird die Spule bestromt, so bildet sich ein Magnetfeld und der E-Block (die Arme) bewegen sich zu einer Richtung oder zur anderen je nach Stromrichtung des Magnetfeldes.

Scheiben oder Platten (6): Die Festplatte besteht in der Regel aus einer bis vier drehbaren gelagerten feste Platten, die übereinander montiert sind. Die Scheiben bzw. Platten sind in der Regel entweder aus Glaskeramik oder Aluminium. Die Oberfläche der gleichen ist mit einer magnetisierbaren Oberfläche beschichtet, in der Daten elektro-magnetisch gespeichert werden. (thin film). (7) Die letzte Beschichtung ist eine dünne ölige Schutzschicht. Die Scheiben werden beidseitig beschrieben, das heißt, beide Seiten der Platten beinhalten Information.

Achse (8): Es gibt zwei Achsen, einmal die des Lese-/Schreibkopfes und zweitens die der Magnetscheiben.

Chassis (9): Dies ist die Struktur, in der die unterschiedlichen Komponenten der Festplatte eingebaut werden, jedoch in keinem Moment wirkt es bei der Datenspeicherung mit.

Elektronik oder Leiterplatte (10): sehr bekannt auch unter den Namen. Platine. (engl. printed circuit board, PCB bzw printed wiring board, PWB). Es werden elektronische Bauteile verbunden ohne Nutzung von Kabeln.

Motor der Festplatte (11): Die Magnetscheiben werden vom Motor angetrieben. Die Rotationsgeschwindigkeit spielt eine wichtige Rolle bei der Gesamtperformance der Festplatte.

Schnittstelle bzw. Bus (12): ist eine Anschlußleiste für den Datentransfer zwischen Computersystem und Festplatte.

Power supply (13): Der Connector verbunden mit einen Futterkabel sorgt für die Stromversorgung der Festplatte.

Sie können Ihren Computer gegen Datenverlust absichern, um das Risiko möglichst gering zu halten. Aber sollten Sie Festplatten recovery brauchen, dann rufen Sie uns an, wir helfen Ihnen weiter.

1. Der zeitliche Verlauf

Am Anfang der PC-Ära wurden die Computer nicht mit Festplatten ausgestattet. Diese waren für die meisten Anwender und Firmen viel zu teuer. Hier wurden lediglich Diskettenlaufwerke eingebaut – im IBM PC 1980 z.B. zwei 5 ¼" Drives mit voller Bauhöhe und einer Speicherkapazität von jeweils 120 kByte. Drei Jahre später (1983) baute IBM schon eine damals gewaltige 10 MByte Festplatte – ebenfalls voller Bauhöhe – in seinen XT ein. Diese Speicherkapazität erscheint heute im Angesicht der gängigen Gigabyte-Platten winzig.

Im Laufe der Zeit haben sich vier Schnittstellen zum Anschluß an den Computer bewährt, anhand derer sich auch die dazugehörigen Festplatten identifizieren lassen:

- Die ST506/ST412-Schnittstelle,

- die ESDI-Schnittstelle,

- die SCSI-Schnittstelle,

- die (E)IDE-Schnittstelle.

2. Aufbau und Funktionsweise von Disketten und Festplatten

Der mechanische Aufbau einer Festplatte ist dem einer Diskette sehr ähnlich.

1. Disketten

Eine Diskette wird grundsätzlich in einzelne Spuren aufgeteilt, die als konzentrische Kreise in gleichmäßigem Abstand über die Oberfläche der Magnetscheibe verteilt sind. Die Spuren werden mit Nummern von 0 bis N bezeichnet, wobei die äußerste Spur grundsätzlich die Nummer 0 trägt, die darauf folgende die 1 usw. Jede Spur ist in eine konstante Anzahl von Sektoren aufgeteilt, die die Spur in einzelne Abschnitte gleicher Größe unterteilt. Auch die Sektoren werden von 1 bis n gezählt. Die Anzahl der Sektoren und Spuren ist vom Laufwerksformat abhängig.|

5 ¼ Zoll |

3 ½ Zoll |

||||||||

|

Sektoren / Spur |

Spuren / Seite |

Kapazität / Seite |

Daten transfer-Rate |

Sektoren / Spur |

Spuren / Seite |

Kapazität / Seite |

Daten transfer-Rate |

||

|

SD |

4 |

40 |

80/160 KByte |

128KBit/s |

- |

- |

- |

- |

|

|

DD |

8 |

40 |

160/320 KByte |

250KBit/s |

- |

- |

- |

- |

|

|

DD |

9 |

40 |

180/360 KByte |

250KBit/s |

9 |

80 |

720 KByte |

250KBit/s |

|

|

HD |

15 |

80 |

1,2MB |

500KBit/s |

18 |

80 |

1,44 MB |

500KBit/s |

|

|

EHD |

- |

- |

- |

- |

36 |

80 |

2,88 MB |

1 Mbit/s |

|

Alle Diskettenlaufwerke und Formate arbeiten mit 300 Umdrehungen/min (HD- 5¼-Zoll: immer mit 360 Umdrehungen/min).

2. Festplatten

Bei Festplatten liegen mehrere Magnetplatten übereinander, die, genau wie eine Diskette, in Sektoren und Spuren aufgeteilt sind. Je nach Festplatten - Model haben die einzelnen Platten zwei Schreib- und Leseköpfe (oben und unten. Siehe Bild). Sie sind über den Schreib-/Lesearm miteinander verbunden, so daß ein Spurenwechsel immer für alle Scheiben gleichzeitig vollzogen wird.

Deshalb hat man den Begriff "Zylinder" eingeführt. Er beschreibt sozusagen die Anzahl der untereinanderliegenden Spuren.

Im Gegensatz zur Diskette rotieren die Platten ständig und nicht nur dann, wenn sie angesprochen werden. Es gibt allerdings im Power Management eine Option, in der Festplatten nach einer gewissen Zeit (variabel) abgeschaltet werden können. Diese schalten sich dann bei Zugriff wieder an.

3. Der Interleave-Faktor

Bei der Low-Level- oder auch Vor-Formatierung werden die Sektoren einer Festplatte physikalisch durchnumeriert. Dies geschieht schon bei der Produktion der Platte. Bei dieser Numerierung beginnt man mit dem ersten Sektor, wobei jeder folgende Sektor um 1 erhöht wird.

Es wäre optimal, wenn innerhalb einer Umdrehung der Platte alle Sektoren einer Spur gelesen werden könnten. Die Elektronik im PC muß hierzu die Daten so schnell verarbeiten, wie sie von der Festplatte geliefert werden. Bei heutigen Controllern ist dies kein Problem mehr.

Ältere Controller (z.B. ST506/412) und PCs (8088/8086-Prozessor) hingegen schaffen dies nicht. Sie können die Daten nicht so schnell verarbeiten, wie die Festplatte sie anliefert.

Wenn die gelieferten Daten vom Controller verarbeitet sind ist der nächste zu lesende Sektor bereits am Magnetkopf vorbeigelaufen. Der Controller muß nun warten, bis der nächste gewünschte Sektor wieder am Magnetkopf vorbeikommt, damit die Festplatte diesen lesen und der Controller ihn verarbeiten kann. Währenddessen fliegen dann schon wieder die nächsten Daten am Magnetkopf vorbei.

Wenn man die Sektoren anders anorden würde (also nicht der Reihe nach: Sektor 1, Sektor 2, ...) könnten man sie der Geschwindigkeit des Controllers und des PCs anpassen. Hierbei würde man hier erhebliche Geschwindigkeitsvorteile erzielen.

Da es zu kompliziert ist, die Sektoren anders anzuordnen, ändert man lediglich die Numerierung der einzelnen Sektoren.

=>Es wird eine logische Sektornumerierung eingeführt, die mir der physikalischen (tatsächlichen) Numerierung nicht übereinstimmt. Die logische Sektorennummer wird in dem sogenannten Header eines Sektors gespeichert.

Das Verhältnis zwischen den beiden Numerierungen wird als Interleave-Faktor bezeichnet.

1:1 fortlaufende Numerierung (bei dem heutigen Stand der Technik standart)

1:2 übernächster Sektor hat die folgende Sektornummer.

1:3 zwei Sektoren werden übersprungen.

Beispiel für einen Interleave von 4 (bei 17 Sektoren pro Spur):

1. Umdrehung:

1 - 14 - 10 - 6 - 2 - 15 - 11 - 7 - 3 - 16 - 12 - 8 - 4 - 17 - 13 - 9 - 5

2. Umdrehung:

1 - 14 - 10 - 6 - 2 - 15 - 11 - 7 - 3 - 16 - 12 - 8 - 4 - 17 - 13 - 9 - 5

3. Umdrehung:

1 - 14 - 10 - 6 - 2 - 15 - 11 - 7 - 3 - 16 - 12 - 8 - 4 - 17 - 13 - 9 - 5

4. Umdrehung:

1 - 14 - 10 - 6 - 2 - 15 - 11 - 7 - 3 - 16 - 12 - 8 - 4 - 17 - 13 - 9 - 5

Den Interleave Faktor kann man mit bestimmten Programmen zur Low-Level-Formatierung bestimmen und abändern. Dies sollte man jedoch auf gar keinen Fall bei (E)IDE - oder SCSI - Platten tun, da bei diesen ein Interleave von 1:1 vom Hersteller spezifiziert ist.

4. Das Zone-Bit-Recording

Bei Festplatten mit ST506/412 Schnittstelle kann auf jeder Spur die gleiche Menge Daten gespeichert werden; d.h., daß auf den äußeren Spuren genau so viele Sektoren sind wie auf den inneren Spuren. Die Länge der inneren Spur gibt also die Anzahl der Sektoren für die gesamte Plattenoberfläche vor. Dadurch wir auf den mittleren und äußeren Spuren sehr viel Platz verschenkt, da physikalisch in den äußeren Spuren mehr Platz ist, als auf den inneren.

Durch das Zone-Bit-Recording wird die Plattenoberfläche in mehrere Zonen eingeteilt. In den inneren Zonen ist die Anzahl der Sektoren pro Spur geringer als in den äußeren Zonen. Die Datendichte bleibt somit auf der gesamten Oberfläche gleich. Durch dieses Verfahren wird die Speicherkapazität um ca. 30% bei gleicher Plattenoberfläche vergrößert.

Das Zone-Bit-Recording geschieht völlig Festplatten-intern, d.h., das PC BIOS bzw. der Controller bekommt davon nichts mit.

Deshalb auch die Unterscheidung:

- logisches Mapping (CHS Werte des Bios/Controllers)

- physikalisches Mapping (wirkliche CHS Werte der Festplatte)

Aber nicht nur das: dadurch, daß in den äußeren Spuren mehr Daten liegen als in den inneren, können pro Umdrehung in den äußeren Spuren auch mehr Daten gelesen werden. Die Datenübertragungsrate nimmt von innen nach außen ab.

Dieses Verfahren wird erst seit den neueren (E)IDE und SCSI Platten häufiger angewandt, da es höhere Anforderungen an die Elektronik der Platten stellt. Da in jeder Zone die Länge der Spuren unterschiedlich ist, muß die Lese-Schreib-Elektronik für jede Zone neu eingestellt werden.

5. Das Mapping

Mapping beschreibt die Art und Weise, in welcher Anordnung die Daten auf die Festplatte geschrieben werden.

Hierzu gibt es drei Möglichkeiten:

- vertikates Mapping

- horizontales Mapping

- zonenweise horizontales Mapping

Beim 'vertikalen Mapping' beginnt der Schreibvorgang auf der Oberfläche der ersten Magnetplatte. Wenn die erste Spur vollgeschrieben ist, wird die Unterseite der ersten Magnetplatte, dann die erste Spur der Oberseite zweiten Magnetplatte usw. vollgeschrieben. Sind alle Spuren des ersten Zylinder voll, wird erst der Spurenwechsel durchgeführt. Der Vorteil daran ist, daß ein Kopfwechsel normalerweise wesentlich schneller geht als ein Spurwechsel, da dieser nicht mit einer mechanischen Bewegungen verbunden ist.

Beim 'horizontalen Mapping' arbeitet die Platte erst die ganze Oberfläche ab, bevor sie auf den nächsten Kopf wechselt. Diese Methode ist etwas langsamer als die anderen zwei Methoden.

Bei einigen Festplatten dauert Zonenwechsel besonders lang, da in der Elektronik erst noch umgerechnet werden muß, wie viele Sektoren in welcher Zone sind. So wird ein horizontales Mapping für jede einzelne Zone durchgeführt, damit die Umrechnung in der Elektronik seltener durchgeführt werden muß. Man nennt dieses Verfahren daher auch das 'zonenweise horizontale Mapping'.

6. Die Bauform

Die heutzutage übliche Bauform einer Festplatte ist 3 ½'' (ca. 8,5cm) Breite und 1'' (2,54cm) Höhe.

Diese Baugröße löste die 5 ¼'' (ca. 8,9cm) großen Festplatten ab. Sie treten heute nur noch selten bei großen SCSI - Hochleistungsplatten über 9GB und ganz selten bei IDE Platten auf (z.B. IDE Platte Quantum Bigfoot TX).

Ganz zu Beginn der Festplattentechnik hießen Festplatten "Winchesterdrives" und sie waren bis zu 8'' (ca. 20,3cm) groß.

Die Miniaturiesierung der Festplatte gewinnt mehr und mehr an Bedeutung.

Man Festplatten im 2,5'' Format entwickelt, die z.B. in Laptops angewandt werden. Sie sind aber nicht nur schmaler, sondern auch niedriger geworden: Standard sind in 1'' und 1,6''. Bei Laptops sind 0.5", 0.66" oder 0.75" üblich. Ein nachteil ist, daß sie langsamer sind als 3 ½ '' Platten.

Eine weitere Miniaturentwicklung ist die PCMCIA Festplatte. Sie ist nur 1,8'' breit, aber leider in Ihrer GB-Größe beschränkter als normale Festplatten (höchstens 3,6GB).

7. Die Kalibrierung

Durch Temperaturschwankungen während des Betriebes (Warmlaufen, Umgebungswärme) können sich die Datenscheiben von Festplatten um einen winzigen Betrag ausdehnen bzw. zusammenziehen. Da die einzelnen Spuren ziemlich eng beieinanderliegen und immer näher zusammenrutschen, kann dies dazu führen, daß der Schreib- /Lesekopf der Festplatte die gesuchte Datenspur nicht mehr findet bzw. schlechte Signale bekommt.

Um dies zu verhindern, besitzen Festplatten seit langem die Fähigkeit zur thermischen Rekalibrierung. Dabei fährt der Schreib- /Lesekopf an eine definierte Position, wo er anhand der gelesenen Signale seine relative Position zur Plattenoberfläche bestimmt. Anschließend kann er wieder an seine ursprüngliche Position zurückfahren, um seine Arbeit fortzusetzen.

Normale Anwendungen beeinflußt die Rekalibrierung nicht negativ. Jedoch dort wo ein konstanter Datenfluß garantiert sein muß, kann dies zu Problemen führen, da dieser Vorgang zwischen 0,5 und 2 Sekunden dauert und der Schreib- /Lesekopf seine eigentliche Arbeit unterbricht.

Abhilfe können hier nur größere Caches oder bessere AV-Platten schaffen, die keine thermische Rekalibrierung benötigen.

3. Handling

Eine Festplatte darf niemals unter normalen Raumbedingungen geöffnet werden, denn damit ist Sie auf jeden Fall defekt. Der Staub der Umgebung setzt sich sofort auf die Plattenoberflächen ab. Da der Schreib- / Lesekopf zwischen 0,3 bis 0,5 µm über der Plattenoberfläche schwebt, wirken Staubkörnchen auf der Magnetscheibe wie Felsen auf der Autobahn (siehe Poster im Klassenzimmer).

Mit Festplatten sollte sehr vorsichtig umgegangen werden. Schon geringe Stöße können einen sogenannten "Head-Crash" hervorrufen, bei dem die Lese- /Schreibköpfe auf die Oberfläche der Platte aufschlagen und Mikropartikel aus dem Trägermaterial herausschlagen. Es entstehen an der Stelle regelrechte "Schlaglöcher", die, genau wie die herausgeschlagenden und umherfliegenden Teilchen, nicht nur die Daten an der Stelle zerstören, sondern auch den Lese- /Schreibkopf beschädigen.

Neuere Platten senken ihren Kopf auf die Parkspur der Festplatte ab und "rasten dort ein", wenn sie abgeschalten werden. Dies soll Beschädigungen durch Transport verhindern.

Head-crash bei einer Festplatte

Brände führen zu zwei weiteren Schäden:

Feuerschäden und Wasserschäden. Da in solchen Fallen Datensicherungen wie DAT - Bänder meist vernichtet oder defekt sind, bieten Festplatten die einzige Möglichkeit, Daten zu rekonstruieren.

Selbst bei einem völlig verbrannten Rechner ist Datenrettung möglich, solange die Temperatur der Plattenoberfläche nicht zu hoch war; genauer gesagt, wenn sie unter der Curie-Temperatur blieb, bei der die Magnetisierung durch die Hitze verändert wird.

Festplatte nach einem Brand

Diese Festplatte ist durch Wasser korrodiert. Ein unsachgemäßer

Kopierversuch führte anschließend zu einem Head-crash im inneren Bereich.

Festplatten, speziell die Elektronik, sind besonders empfindlich gegenüber elektrostatischen Ladungen. Man sollte sich deshalb, bevor man Festplatten berührt, erden, um sich zu entladen. Dies geschieht am besten dadurch, daß man einen Metallgegenstand berührt, der Kontakt zur Erde hat (DIES IST KEIN WITZ!!!).

4. Zur Geschichte der verschiedenen Schnittstellen

Der Dateizugriff über Int 13h

Auch Festplattenzugriffe heutiger Betriebssysteme wie Windows 95 oder NT basieren auf den anfang der 80er entwickelten DOS-BIOS-Modellen. Die Programme arbeiten hierbei auf der Basis von Dateinamen. Wenn eine Textverarbeitung z.B. ihr Dokument speichern will, tut sie das, indem sie dem Betriebssystem den Auftrag gibt, die Daten in eine mit Namen benannte Datei zu speichern. Beim Laden ist dies ebenso.Nun befindet sich auf jeder Partition eines Laufwerks die sogenannte FAT (file allocation table), eine Tabelle, die diese Dateinamen ihren physikalischen Sektoren zuordnet. Das Betriebssystem gibt nun ans BIOS den Befehl, diese Datei zu lesen oder zu schreiben. Dies geschieht über den BIOS-Interrupt 13h. Da diese Programmierschnittstelle betriebssystemunabhängig ist, können dieselben Laufwerke auch unter anderen Betriebsystemen verwendet werden – auch wenn sie andere Dateiformate verwenden. Da die Festplatten im BIOS angemeldet sind, braucht das Betriebssystem keine Informationen über den verwendeten Festplattentyp zu haben. Das BIOS gibt die Anfragen lediglich über Int 13 an die Schnittstelle der Festplattencontrollersoftware weiter – z.B. bei IDE ATA.

Die ST509/ST412-Schnittstelle

|

Anfang der 80er Jahre entwickelte die Firma Seagate eine Schnittstelle zur Ansteuerung von Festplatten, die sie ST506 (oder auch Shugart-Schnittstelle) nannten. Das "ST" in der Namensgebung hat Seagate bis zu den heutigen Produkten beibehalten. Diese Schnittstelle konnte zunächst die Hauseigene Platten mit 5 MByte verwalten. Kurze Zeit später entwickelte sie Seagate weiter zur ST412-Schnittstelle, die nun auch größere Platten bis zu 140 MByte (zunächst die o.g. 10 MByte-Platte) verwalten konnte. Dieser Anschluß war Hard- und Softwaretechnisch mit der ST509 kompatibel und bedurfte keiner BIOS-Änderung des PCs. Auch heutige BIOS-Versionen haben eine Abwärtskompatibilität hierzu beibehalten, was man an der dortigen Liste der Festplattentypen erkennen kann, die von 10 bis 152 MBytes reicht. Dies rührt auch daher, daß der Anschluß einer Platte über das ST412-Interface bis Anfang der 90er die am weitesten verbreitete Methode war. |

| Der Controller |

|

ST509-Controller und Festplatte stellen zwei getrennte Geräte dar, da der Controller mit einer eigenständigen Intelligenz ausgestattet ist und als Erweiterungskarte in einen freien ISA-Slot gesteckt wird. Der Controller kann maximal 2 Festplatten ansteuern und ist meist als Kombicontroller ausgerüstet, der weitere Anschlüsse für bietet. In Hochleistungssystemen verwendete man auch Controller zum Anschluß von vier Festplatten. Der Controller wird über zwei Leitungen mit der Festplatte verbunden. Diese sind meist als Flachbandleitung mit je einem Pfostenstecker und einem Platinenstecker ausgestattet. Diese haben außer der Farblichen Markierung und der aufgedruckten "1" keine Verpolungssicherheit. |

Abb: Seagate-Festplatte ST125 mit ST509/412-Schnittstelle

Die Installation

Früher hatten die Computer der XT-Kompatiblen noch kein so komfortables menügesteuertes BIOS wie heutige Rechner. Folglich war es auch etwas umständlicher eine Festplatte in solch einem System einzurichten.Nach dem physikalischen Einbau von Platte und Controller in den Computer, mußte man die Festplatte im BIOS anmelden. Dies war nicht immer einfach, da nur Platten gewählt werden konnten, die in dieser Liste enthalten waren. Wenn man sein Laufwerk nicht dort aufgelistet fand mußte man den Typ wählen, der in jedem Wert (Anzahl der Zylinder, Sektoren, Köpfe) höchstens genauso groß war wie der gewünschte. Hierbei verschenkte man mit Sicherheit einige kostbare Speicherkapazität, da man so Sektoren, Zylinder oder gar Köpfe gar nicht ansteuern konnte. Wählte man einen höheren Typ, so hatte das unmittelbare Datenverluste oder gar Beschädigungen der Festplatte zur Folge, da nun Bereiche angesteuert wurden, die physikalisch nicht vorhanden waren.

Nach der Anmeldung war eine Low-Level-Formatierung notwendig, die man mit Hilfe eines Tools wie dem DiskManager der Firma Ontrack bewerkstelligte. Eine zweite Möglichkeit bot der DOS-Debugger, über den man eine im Controller-BIOS verankerte Routine zur Low-Level-Formatierung aufrief. Eine Low-Level-Formatierung teilt die Festplatte in Spuren bzw. Zylinder und diese in Sektoren ein. Dies macht auch die Formatierung derselben Festplatte (wenn sie dazu geeignet ist) entweder mit MFM, das generell 17 Sektoren pro Spur hat, oder mit RLL möglich, das 26 bzw. 34 Sektoren pro Spur verwendet. Beim Low-Level-Formatieren war beim ST509/412 die Eingabe der defekten Sektoren vom Benutzer nötig, um Datenverluste zu vermeiden. Diese Liste wurde vom Hersteller mit dem Laufwerk ausgeliefert. Außerdem war die Angabe des gewünschten Interleave-Faktors notwendig, der bei diesem Platten-Typ zunächst beim Einbau in einen XT 1:6 und später beim AT 1:3 betrug. Danach wurden die gewünschten Partitionen mit dem DOS-Programm FDISK eingerichtet und diese anschließend mit dem High-Level-Formatbefehl FORMAT zur Benutzung fertig eingerichtet.

IBM übernahm wie gesagt die ST509/412-Schnittstelle in seinem XT-Modell, womit man sich auf einen niedrigeren Standard festlegte. Der ST509/412 kann nämlich nur maximal 1024 Zylinder mit jeweils 63 Sektoren und 16 Köpfen adressieren, was mit der DOS-Sektorgröße von 512 Byte eine maximale Festplattenkapazität von 504 MByte ergibt. Mit einem Trick konnte man das BIOS überlisten, indem man ihm bei einer größeren Festplatte (bis 1 GByte) vorgaukelte, 2 kleine Platten installiert zu haben.

Die ESDI (Enhanced Small Devices Interface) –Schnittstelle

Die ESDI-Schnittstelle bezeichnet eine 1983 von Maxtor vorgestellte Weiterentwicklung der ST509/412-Schnittstelle. IBM setzte auch diesmal wieder diesen neuen Typ als erste in seinen PS/2-Modellen ein. Es bestehen keine äußerlichen Unterschiede zu den vorherigen Laufwerken, auch nicht im Anschlußverfahren, das hierbei wieder mittels getrennter Steuer- und Datenleitungen vollzogen wird. Auch auf die Registerkompatibilität legte Maxtor wert. Somit sind diese Festplatten auch in den vorhandenen Systemen mit dem alten BIOS einsetzbar. Probleme bereitete allerdings die Kompatibilität der Geräte verschiedener Hersteller untereinander. Obwohl man aufgrund des äußeren Erscheinungsbildes glauben könnte, man könne ESDI- mit ST509/412-Geräten kombinieren, funktioniert dies nicht. Für Datenübertragung wird bei ESDI nämlich im gegensatz zur Vorgängerschnittstelle kein analoges Verfahren mehr eingesetzt, sondern eines nach der digitalen NRZ-Kodierung. Dies kommt daher, daß man einen Teil derIntelligenz auf der Festplatte unterbringt: den sogenannten Datenseparator. Er bereitet die gelesenen bzw. zu schreibenden Daten auf und überträgt nur die Nutzdaten, was eine bessere Ausnutzung der vorhandenen Bandbreite auf der Datenleitung und somit eine Erhöhung der Übertragungsrate ermöglicht. Ein weiteres Verfahren macht ein ESDI-Laufwerk schneller: Die Daten werden in einem Sektorpuffer von meist 64kByte zwischengespeichert. Dies ermöglicht einen Interleave-Faktor von 1:1. Dadurch erhöht sich die Übertragungsrate auf standardisierte 10,15, 20 und sogar 24 MBit/s, was maximal etwa 3 MByte/s beträgt. Meist verwenden ESDI-Festplatten das RLL2.7-Format zur Datenaufzeichnung. ESDI wird oft auch als Vorläufer von SCSI bezeichnet, da man an den ESDI-Controller auch Bandlaufwerke zur Datensicherung anschließen kann.

Abb: Seagate-Festplatte ST1100 mit ESDI-Schnittstelle

Die Installation

Um eine ESDI-Festplatte in einem PC betreiben zu können, muß diese im BIOS angemeldet werden. Da die meisten BIOSe nur eine begrenzte Auswahl an Festplatten unterstützen, ist es schwer, den passenden Typ zu finden. Deshalb wird hierbei vom Controller ein Translation-Mode verwendet, der die Festplattendaten so umsetzt, daß die Platte mit ihrer maximalen Kapazität betrieben werden kann. Hierzu trägt man im BIOS

"Typ 1" ein, was dem BIOS signalisiert, daß überhaupt eine Festplatte vorhanden ist. Der Controller fordert dann die Laufwerksdaten von der Festplatte an und überlagert damit das PC-BIOS. Dadurch kann das Betriebssystem die Platte voll ausnutzen. Dieser Translation-Mode wird auch dazu eingesetzt, Geräte mit mehr als 1024 Zylindern, 63 Sektoren oder 16 Köpfen einzusetzen.

Neben den Laufwerksdaten haben die Hersteller von ESDI-Geräten auch die Fehlerliste darauf abgelegt. Dadurch brauchen diese Informationen bei der Low-Level-Formatierung nicht mehr per Hand eingegeben werden. Ansonsten funktioniert dieser Arbeitsschritt genauso wie bei ST509/412-Festplatten mit Hilfe im Controller-BIOS implementierter Funktionen, die über den DOS-Debugger aufgerufen werden. Danach wird die Platte wie üblich partitioniert und formatiert.

Die SCSI (Small Computer System Interface) - Schnittstelle

Bereits in den 70er Jahren wurde die SCSI-Schnittstelle entwickelt, der Standard wird ständig erweitert. Sie stellt eine große Flexibilität zur Verfügung, da an ihr nicht nur Festplatten, sondern auch andere Geräte wie Streamer, Scanner, CD-ROMs usw. angeschlossen werden können – maximal 7 bzw. 15 Geräte pro Controller. Der Controller trägt hierbei den Namen Host-Adapter. Die eigentlichen Controller befinden sich auf den Geräten selbst, was sie in gewissem Sinne "intelligent" macht.Eine SCSI-Festplatte wird nicht im PC-BIOS eingetragen, da der Host-Adapter ein eigenes BIOS enthält, das den Zugriff steuert. In neueren Systemen kann man sogar bei Mischbetrieb von SCSI-Festplatten und den folgenden IDE-Laufwerken die Bootreihenfolge im PC-BIOS wählen. Dies macht dieses Konzept noch flexibler.

SCSI-Laufwerke werden über eine Bus-Verkabelung mit einer 50 bzw. 68 poligen Daten-/Steuerleitung, an denen bis zu 7 verpolungssichere Pfostenstecker oder Mini-Sub-D-Stecker angebracht sind, mit dem Host-Adapter verbunden. Sie wurden ursprünglich für den Einsatz in Servern und Hochleistungsworkstations entwickelt und liegen auch heute noch preislich über dem Niveau von IDE-Festplatten.

SCSI-wurde in einem vorherigen Vortrag ausführlich behandelt und würde auch diesen Rahmen sprengen. Deshalb belasse ich es bei diesem kurzen Überblick.

Abb: Seagate-Festplatte ST11201N - Swift SCSI mit SCSI-Schnittstelle

Die IDE (Integrated Device Electronic)-Schnittstelle

Die IDE-Schnittstelle – auch AT-Bus-Schnittstelle genannt – wurde 1984 von Conner entwickelt. Der grundlegende Gedanke dieses Systems ist auch in der Namensgebung zu erkennen: die Elektronik ist fast vollständig auf der Festplatte untergebracht. Im prinzip handelt es sich lediglich um eine Verlängerung des AT-Bus, der ab dem 80286 eingesetzt wurde – daher der Beiname. Am Anfang gab es auch XT-Bus-Festplatten, die aber nur kurze Zeit überlebten, da die XTs vom Markt verschwanden. Auf dem Adapter zum AT-Bus, der meist als Multi-I/O-Karte ausgeführt ist, befinden sich lediglich Controllerbausteine für die Diskettenlaufwerke, eine Adressendekodierungsschaltung für die Portadressen und Daten- und Adressentreiberbausteine. Oft sind auch Parallele und Serielle Schnittstellen implementiert. Bei Boards, die ab dem 80486 zum Einsatz kamen, ist der Adapter fast immer auf dem Motherboard integriert – also onboard. An die normalen IDE-Schnittstelle lassen sich maximal zwei Festplatten über eine 40polige, maximal 18" lange Daten-/Steuerleitung per Bus anschließen. Diese müssen dann auf ihre Rolle in diesem Bus eingestellt werden. D.h., ein Laufwerk wird als "Master" und das andere als "Slave" gejumpert. Ist nur eine Platte angeschlossen, sollte diese als "Single" gejumpert sein. Auch bei IDE werden verpolungssichere Pfostenstecker verwendet, die außerdem mit einem Pfeil an der farblich markierten Leitung 1 vesehen sind. Bei den ersten IDE-Festplatten waren jedoch noch keine Kunststoffrahmen um die Pfosten-Stiftleiste angebracht, was eine Vertauschung ermöglichte. Auch die Stiftleisten auf den Controllerkarten und Motherboards besitzen erst seit wenigen Jahren solche Verpolungssicherungen.IDE-Festplatten sind denkbar einfach im PC-BIOS anzumelden. Bei allen modernen BIOSe gibt es einen sogenannten "User Typ". Hierbei kann der Benutzer selbst die Laufwerksdaten ins BIOS eintragen. Leider gilt auch hierbei die Beschränkung der CHS-Methode (cluster,head, sector) mit ihren 1024 Zylindern, 63 Sektoren und 16 Köpfen, was multipliziert mit der DOS-Sektorgröße von 512 kByte eine maximale Kapazität von 504 MByte ergibt. Diese Einschränkung rührte noch von der BIOS-Kompatibilität – es konnte nur 1024 Zylinder verwalten – zu früheren Standards her, denn IDE wurde eigentlich für 255 Sektoren auf 65536 Zylindern bei 16 Köpfen konzipiert.

Größere Festplatten konnten deshalb nur mit speziellen Hilfsprogrammen wie dem OnTrack DiskManager benutzt werden, der sich direkt in den MBR (Master-Boot-Record) des Laufwerks einnistet und für die nötige Anpassung sorgt. Wird die Platte nun in einem anderen System an einem fortschrittlicheren Anschluß betrieben, droht mit einem solchen Hilfsprogramm der Verlust sämtlicher Daten.

Bei IDE wird das Low-Level-Format vom Hersteller ausgeführt und sollte nur im äußersten Notfall, wenn man sowieso nichts mehr an der Platte beschädigen kann, durchgeführt werden. Dies hat den Grund, daß der Hersteller die defekten Sektoren selbst als ungültig markiert, die bei einem Low-Level-Format wieder freigegeben würden. Außerdem verfügen IDE-Laufwerke über ein Verfahren, daß sich ECC (Error Correction Code) nennt und defekte Sektoren während des Betriebs erkennt. Die Logik versucht, beim Erkennen eines solchen beschädigten Sektors den Inhalt auszulesen und in einen freien Bereich zu schreiben. Anschließend wird der defekte Sektor gesperrt.

Der IDE-Controller, der sich auf dem Plattengehäuse selbst befindet, verfügt außerdem über einen Pufferspeicher, der einen Interleave-Faktor von 1:1 ermöglicht und somit den Zugriff beschleunigt.

EIDE (Enhanced IDE)

EIDE ist eine 1993 von Western Digital ins Leben berufene Weiterentwicklung der IDE-Schnittstelle und behebt die Einschränkungen bezüglich der Speicherkapazität unter Beibehaltung der Kompatibilität.Die EIDE-Schnittstelle findet man auf Mainboards ab dem 80486 und auf speziellen Erweiterungskarten. Sie sieht den Anschluß von bis zu vier Geräten auf zwei IDE-Kanälen vor. Diese sind mit "primary" und "secondary" IDE bezeichnet. Auch hier muß eine Master-Slave-Einstellung auf jedem Kanal stattfinden. Im BIOS können daher auch vier Festplatten eingetragen werden, die nun als Hauptverbesserung eine größere Kapazität als 504 MByte besitzen dürfen. Eine Kapazität von bis zu 7,8 GByte wurde erreicht, indem man das sogenannte LBA (Logical Block Adressing) einführte, das dem BIOS 255 Köpfe vorspiegelt, obwohl eine solche Platte niemals soviele Köpfe besitzt. 255 ist nämlich die größte mit dem Festplatteninterrupt 13h adressierbare Einheit. Der Controller setzt die Steuerinformationen dann auf die gesteigerte Anzahl an Zylindern und Sektoren um, so daß das BIOS mit der großen Platte zurecht kommt. Dieses Verfahren nennt man auch CHS-LBA.

Abb: Seagate-Festplatte ST34520A - Medalist Pro mit EIDE-Schnittstelle

Mittlerweile ist man jedoch bei weitaus größeren Festplatten angelangt, die neue Tricks nötig machen. Man benutzt eine Int 13 Erweiterung, die man auf neuen Boards schon im BIOS implementiert hat. Für ältere BIOSs steht meist ein Update zur Verfügung oder man verwendet wieder ein Hilfsprogramm der Plattenherstellers, das sich in den Bootsektor einnistet. Das Problem besteht nämlich darin, daß die ATA-Spezifikation zwar eine 28 bit-Adresse verwendet, die maximal 137 GByte adressieren könnte, von den älteren BIOSe aber nur 26 bit ((7,8 GByte) mittels Int 13h angesprochen werden können. Bei 137 GByte liegt also die nächste Begrenzung der Festplattenkapazität, die jedoch erst in einigen Jahren überwunden werden muß – und auch nicht unbedingt von EIDE, sondern einer der zukünftigen Schnittstellen.

Wegen des Zone-Bit-Recordings müßten außerdem verschiedene Einstellungen für die verschiedenen Zonen der Festplatte vorgenommen werden, was jedoch kaum praktikabel ist und die bestmögliche Ausnutzung per Translation-Mode vorsieht.

Ein weiterer Vorteil von EIDE ist die Anschlußmöglichkeit für andere Geräte als Festplatten. So lassen sich z.B. CD-ROMs und ZIP-Drives mit der EIDE-Schnittstelle verbinden. Dies beruht auf der softwaretechnischen erweiterung des ATA-Befehlssatzes, der sich ATAPI (AT Attachment Packet Interface) nennt. Diese Tatsache macht die wesentlich preisgünstigeren EIDE-Geräte genauso flexibel wie SCSI. Festplatten werden mit dem ATA Befehlssatz (Advanced Technologie Attachment) angesprochen.

Da IDE-Festplatten über einen speziellen Stromspar-Befehlssatz verfügen und daher eine geringe Leistungsaufnahme haben, sind sie in ihrer kleinsten 2,5" Bauform prädestiniert für den Einsatz in Laptops und Notebooks.

5. PIO- und DMA-Modes

Bei der Übertragung der Daten vom Speicher über Hauptprozessor und Controller zur Festplatte werden verschiedene Verfahren eingesetzt. Für IDE verwendete man den PIO-Mode 0, was eine maximale Übertragungsrate von 3,33 MByte/s zur Folge hatte. Bei den ersten EIDE-Platten und CD-ROMs werden hingegen PIO-Mode 3 und 4 verwendet. Damit lassen sich maximal 16,66 MByte/s bewegen. Diese Modi belasten aber anders als bei SCSI den Hauptprozessor mit der Übertragungsarbeit. Er muß die Daten aus dem Speicher holen und an den Adapter weiterleiten. Um dies zu umgehen, hat man den DMA-Modus eingeführt. Hierbei wird im Betriebssystem ein Busmaster-Treiber installiert, der den Hostadapter so umprogrammiert, daß dieser die Daten per Busmaster-DMA selbst aus dem Speicher holt.Die neuesten Standards sind Ultra-DMA/33 Ultra-DMA/44 und Ultra-DMA/66. Diese erhöhen die Transferraten auf dem IDE-Bus noch einmal auf 33 bzw. 66 MByte pro Sekunde. Dies ist momentan noch nicht mehr als ein Werbegag, denn kaum eine Festplatte kommt derzeit über die Raten von PIO 4 oder Multiword-DMA 2 heraus.

Die Ultra-DMA-Modi 3 und 4 sehen sogar eine Änderung des Anschlußkabels vor. Der Stecker bleibt zwar ein 40poliger Pfostenstecker, doch die Anschlußadern verdoppeln sich auf 80, da zwischen jede Datenader eine Masseleitung zur Abschirmung eingesetzt wird. Die Stecker gewährleisten die Abwärtskompatibilität.

(E)IDE-Transfermodi

|

Modus |

Übertragungsrate |

Einsatzgebiet |

|

PIO 0 |

3,33 MByte/s |

Standard bei IDE |

|

PIO 1 |

5,22 MByte/s |

selten |

|

PIO 2 |

8,33 MByte/s |

selten |

|

PIO 3 |

11,11 MByte/s |

Standard bei EIDE |

|

PIO 4 |

16,66 MByte/s |

EIDE |

|

Singleword-DMA 0 |

2,08 MByte/s |

Ab ATA-3 nicht mehr definiert |

|

Singleword-DMA 1 |

4,16 MByte/s |

Ab ATA-3 nicht mehr definiert |

|

Singleword-DMA 2 |

8,32 MByte/s |

Ab ATA-3 nicht mehr definiert |

|

Multiword-DMA 0 |

4,16 MByte/s |

selten |

|

Multiword-DMA 1 |

13,33 MByte/s |

selten |

|

Multiword-DMA 2 |

16,66 MByte/s |

Busmaster-DMA bei EIDE |

|

Ultra-DMA 0 |

16,66 MByte/s |

selten |

|

Ultra-DMA 1 |

25,00 MByte/s |

selten |

|

Ultra-DMA 2 |

33,33 MByte/s |

derzeit Standard (seit Intel TX Chipsatz) |

|

Ultra-DMA 3 |

ca. 44 MByte/s |

neu |

|

Ultra-DMA 4 |

ca. 66 MByte/s |

neu |

6. Die Geschwindigkeit einer Festplatte

Die Geschwindigkeit einer Festplatte ist im wesentlich abhängig von drei Faktoren:

1. der Zugriffszeit

2. der Drehzahl

3. dem Cache

Zugriffszeit

Die Zugriffszeit ist die Zeit, die die Festplatte durchschnittlich vom Empfang des Befehls bis zum Lesen des ersten Bits benötigt.Sie setzt sich aus folgendem zusammen:

Zeit für Befehlsdecodierung (das 'Verstehen' des Befehls)

+ Zeit für Kopfpositionierung

+ Head settle Time (Zeit bis der Kopf ruhig über der Spur steht)

+ Latenzzeit (Zeit bis gewünschter Sektor vorbeizieht)

----------------------------------------------------------------

= Zugriffszeit

Die Festplattenhersteller "mogeln ein wenig" bei den Angaben zur Zugriffszeit Ihrer Produkte. So benutzen sie nicht die 'Full Stroke Zugriffszeit'

(Zugriffszeit gemittelt für zufällige Zugriffe über die gesamte

Platte), welche die offizielle Definition ist, sondern benutzen eigene

Definitionen, um dem Laien eine schnellere Zugriffszeit vorzugaukeln.

So benutzt man z.B. Die '1/3 stroke' Zugriffszeit. Diese Zugriffszeit ermittelt die Zeit für zufällige Zugriffe über dem ersten Drittel der Festplatte. Hier ist die Zugriffszeit schneller, da der Lesekopf nicht so weite Strecken zurücklegen muß, wenn er die Zugriffszeit der gesamten Platte mißt. Hinzu kommt, daß eine Festplatte auf den äußeren Spuren schneller ist als auf den inneren, da hier mit einer Umdrehung mehr Daten eingelesen werden, als auf den inneren Spuren.

Üblich sind heutzutage 6 bis 15ms Zugriffszeit, wobei 6-8ms von Hochleistungs-SCSI Platten erreicht werden. 15 bis 20ms werden von älteren Platten erreicht; ältere MFM benötigen mehr als 40 ms.

Die Zugriffszeit ist auch abhängig vom korrekten Einbau der Festplatte. Sind die Schrauben von Gehäuse zu Platte nicht richtig festgezogen, so vergrößert sich die "Head settle Time", was zu einer Steigerung der Zugriffszeit führt. Zu Hardwaredefekten sollte es jedoch nicht kommen.

Drehzahl

Die Drehzahl gibt an, wie oft sich die Scheibe pro min dreht.

Je schneller eine Festplatte sich dreht, desto geringer wird die Latenzzeit.

Latenzzeit: die Zeit, die eine Festplatte benötigt, um die gesuchten Daten, nach korrekter Positionierung des Schreib- /Lesekopfes, unter ihm vorbeizuführen.

Mit der höheren Drehzahl steigt natürlich auch die Datenübertragungsrate (wenn der Festplattencontroller schnell genug ist, was bei heutigem Stand der Technik kein Problem darstellt).

Drehzahl | Anwendung | Anmerkung |

3600 rpm | Billig-(E)IDE HDDs | nicht mehr zeitgemäß |

4500 rpm | Standard bei EIDE | zunehmend von 5400 rpm verdrängt |

5400 rpm | bessere EIDE/SCSI HDDs | merklich lauter als 4500 rpm |

7200 rpm | Hochleistungs-HDDs | meist laut, unangenehmes Pfeifen |

10000 rpm | Hochleistungs-HDDs | meist laut, unangenehmes Pfeife |

Die Speicherkapazität einer Festplatte kann nach folgender Formel berechnet werden:

Speicherkapazität = Anzahl der Zylinder * Sektoren pro Spur * Bytes pro Sektor * Anzahl der Köpfe

Nachteile der höheren Drehzahlen:

Sie erzeugen ein lautes und unangenehmes Pfeifen, weshalb Platten mit hohen Drehzahlen selten auf Arbeitsplatzrechnern verwendet werden. Aber nicht nur der Geräuschpegel steigt, sondern auch die Temperatur der Platten steigt an. Deshalb sollte man solche Festplatten aktiv (mit Lüfter) oder passiv (Kühlrippen) kühlen. Achtet man nicht auf eine anständige Kühlung, sinkt die MTBF (Mean Time Between Failure (Mittlere Zeit bis zum Defekt)).

Cache

Der in einer Festplatte eingebaute Cache dient dazu, das Lesen und zum Teil auch schreiben einer Festplatte zu beschleunigen. Es werden häufig benötigte Dateien nicht immer von der Festplatte nachgeladen, sondern in den Cache geschrieben und wieder gelesen.

Obwohl der Cache im Verhältnis zu mancher Festplatte sehr klein ist, beschleunigt er die Vorgänge erheblich.

Einige Hersteller geben statt der wirklichen Cachegröße den gesamten 'Arbeitsspeicher' der Festplatte an. Im Falle der Quantum Fireball werden von 128 kB 'Cache' ca. 45 kB für die BIOS Routinen abgezweigt, so daß effektiv nur 83 kB Cache zur Verfügung stehen.

SCSI-Platten bieten eine Besonderheit: Sie besitzen einen Schreibcache, der sich per Software ein- und ausschalten läßt.

Diese Software ist z.B. In der c't-Mailbox und auf dem ftp-Server des Heise Verlages unter dem Namen "aspiid15.zip" erhältlich.

Deaktiviert man den Schreibcache, so hat dies zwar eine niedrige Geschwindigkeit, dafür aber eine höhere Datensicherheit zur Folge, da, im Falle eines Absturzes, die Daten im Cache nicht verlorengehen, sondern immer noch auf der Platte vorhanden sind.

Aktuelle Cachegrößen sind: 128/256/512/1024/2048/4096 kByte, wobei 2048/4096kbyte in der Regel nur bei SCSI Hochleistungsplatten auftreten.

Alle Betriebsysteme bieten einen zusätzlichen Softwarecache, der die Festplattenaktivität noch mal beschleunigt. Bei DOS war dies Smartdrive, man konnte aber auch zu anderen Programmen greifen, die nicht aus dem Haus Microsoft kamen. Windows 95 verwaltet seinen Softwarecache selbständig und man hat nur wenig Eingriffmöglichkeiten.

Für Poweruser und für Netzwerkserver ist ein Softwarecache nicht ausreichend. Hier werden gern Cachecontroller verwendet, bei denen ein separater Prozessor auf einer Steckkarte (meist PCI) den Cache verwaltet. Der Cache wird auch auf diesem Controller installiert, ist also unabhängig vom Arbeitsspeicher. Neben der Entlastung der CPU von der Cacheverwaltung verwalten Cachecontroller diesen auch besser.

7. EIDE oder SCSI?

Durch die gesteigerten Übertragungsraten von 33,33 MByte/s bei Ultra-DMA/33, braucht sich EIDE nicht mehr länger hinter SCSI zu verstecken. Das Interface wird zur Zeit noch nicht einmal von den Laufwerken ausgelastet. SCSI ist hingegen flexibler, was Anzahl und Anschlußmöglichkeiten der verschiedensten Gerätegattungen und die Leitungslänge betrifft.

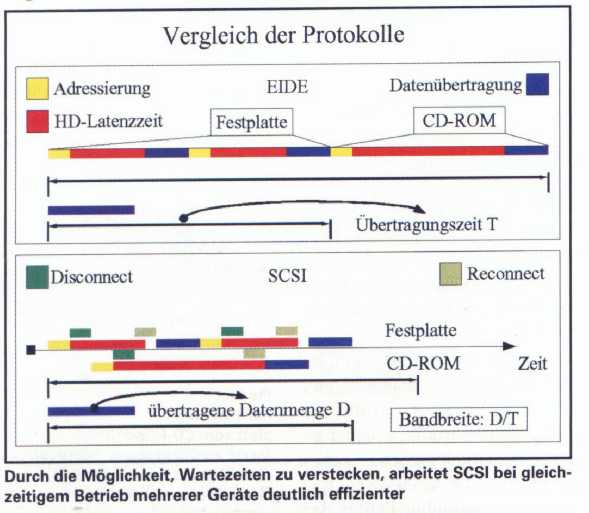

Es gibt jedoch noch einen weiteren übertragungstechnischen Grund, der SCSI zur Geschwindigkeitsüberlegenheit verhilft. Wie in der Abbildung unten zu sehen ist, werden die Anfragen und Datenübertragungen bei IDE schön der Reihe nach (seriell) durchgeführt. Dies wäre nicht sonderlich schlimm, gäbe es keine Latenzzeiten (rot dargestellt), d.h. Wartezeiten, in denen die Festplatte oder das CD-ROM seine Köpfe nach der Übertragung der Adressdaten zur richtigen Position bringt. Während dieser Zeit herrscht praktisch funkstille auf dem Bus, bis die eigentlichen Nutzdaten (blau) übertragen werden.

SCSI verhält sich diesbezüglich anders. Die Geräte beherrschen das sogenannte "Disconnect/Reconnect" (grün/grau), das es ihnen ermöglicht, sich vom Bus abzumelden, nachdem sie die Adressierungsdaten geschickt haben. Während ihrer Latenzzeit geben sie also den Bus für andere Geräte frei, die sich wiederum auch so verhalten. Muß das Laufwerk dann einmal warten, bis der Bus frei wird, stauen sich die Daten im Buffer an und können anschließend mit der maximalen Geschwindigkeit des Interfaces übertragen werden.

Dieses Verfahren zahlt sich aus, da dadurch die Bandbreite, welche sich aus übertragener Datenmenge pro Übertragungszeit errechnen läßt, steigt. Dieser Vorteil tritt besonders in Servern in Erscheinung, bei denen Datenbankanwendungen auf mehrere Festplatten gleichzeitig zugreifen wollen oder auch wenn man Dateien vom CD-ROM zur Festplatte kopiert.

8. Festplattenköpfe

Die Datendichte einer Festplatte bestimmt sich aus der minimalen Fläche, die man für die zuverlässige Speicherung eines Bits benötigt. Je kleiner diese minimale Fläche ist, desto größer ist die gesamte Datendichte der Platte.Diese Fläche hängt hauptsächlich von drei Parametern ab:

1. Speichermaterial

2. der Kopfhöhe

3. der Kopfgröße

zu 1.: bei dem Speichermaterial werden ab und zu geringfügige Fortschritte erzielt.

zu 2.: die Kopfhöhe ist bereits am Limit

zu 3.: die Kopfgröße läßt noch lohnenswerten Spielraum.

Kopftechnologien

Dünnfilmköpfe (Thin-Film)Dünnfilmköpfe schreiben und lesen die Daten mit Hilfe einer Magnetspule auf induktiver Basis.

Induktion:Wenn ein Magnetfeld in Bewegung ist und an einer Spule vorbeigeführt wird entsteht eine Spannung in der Spule, die als Signal interpretiert werden kann.

Gegenteil eines Elektromagneten: Spannung erzeugt ein Magnetfeld. Mit diesem Magnetfeld werden die magnetischen Teilchen auf der Scheibe ausgerichtet. Der Kopf kann seine Polarität ändern und so die magnetischen Teilchen ausrichten.

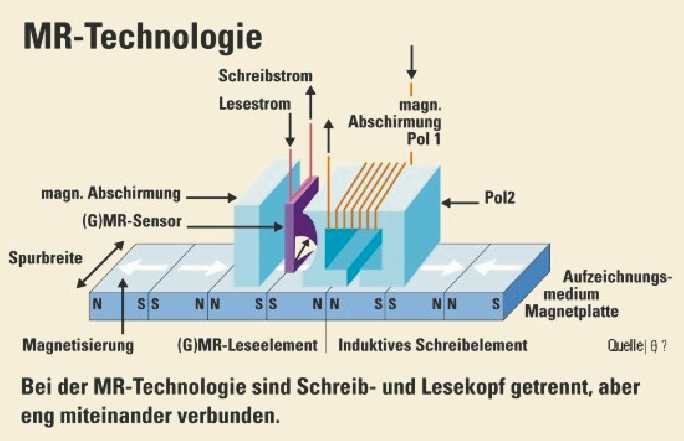

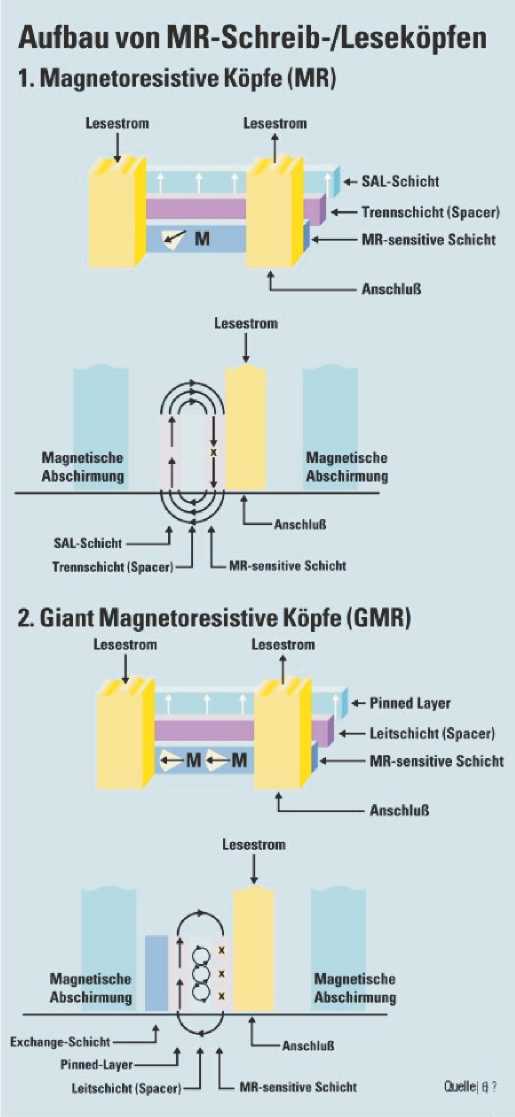

MR Kopf (magnetoresistiv)

Diese Köpfe nutzen die Magnetspule nur noch zum Schreiben. Gelesen wird mit Hilfe eines speziellen Elementes, das im Magnetfeld seinen Ohm'schen Widerstand ändert. Man braucht also nur noch den Spannungsverfall über dem MR-Kopf zu messen, um das Bit zu erkennen. Dieses Verfahren ist wesentlich empfindlicher als die Dünnfilmtechnik. So lassen sich wesentlich höhere Datendichten erzielen, da jede Komponente auf ihren jeweiligen Einsatz hin viel besser optimiert werden kann.

Genauere Erklärung:

Eine Spannung wird schon in die Spule hineingegeben, während der Kopf über die Magnetscheibe saust. An dieser Spule wird ein Magnetfeld in Form des magnetisierten Datenträgers, vorbeigeführt. Dieses Magnetfeld bewirkt durch Induktion in die Spule eine Veränderung des Ohm'schen Widerstandes in der Spule. Die Veränderung des Widerstandes kann auch wieder als logisches Signal interpretiert werden.

Obwohl die MR Technologie schon 1983 von IBM erfunden wurde, wurde sie erst sieben Jahre später in der Praxis eingesetzt.

Typische Flughöhe: 2,79 nm

GMR Kopf (Giant Magnetoresistive)

Diese Technik macht sich die erst 1988 entdeckten Quanteneffekte zunutze. Hier besteht ein Kopf nicht nur aus einer magnetoresistiven Schicht, sondern aus mehreren hauchdünnen Lagen (Hauchdünn bedeutet Stärken bis zu 15 oder gar 5 Atomlagen).

Die GMR - Technik ist momentan noch in der Entwicklungsphase. Die ersten Festplatten, die diese Technik nutzen sind jedoch schon erhältlich:

IBM Platte mit 2,5 Zoll und 8,1GB Kapazität

IBM Platte mit 3,5 Zoll und 16,4GB Kapazität

Angepeilt werden mit Advanced GMR für das Jahr 2004 40GBit pro Quadratinch.

Zusammenfassung

Je höher die Datendichte wird, desto genauer muß auch der Kopf positioniert werden und um so feiner und kleiner muß der Schreib- /Lesekopf werden.

9. Aufzeichnung der Informationen auf Festplatten

Daten werden binär gespeichert. Das bedeutet, daß man eine Darstellungsart für "null" und "eins" findet. Aus technischen Gründen kann man jedoch nicht den einen Zustand als magnetisiert und den anderen Zustand als nicht magnetisiert darstellen.

Man würde eine Folge von magnetisierten und nicht magnetisierten Teilchen erhalten; diese kann der Lesekopf der Festplatte nicht auseinanderhalten. Er wüßte beispielsweise nicht, ob es sich bei dem gelesenen um drei oder fünf Nullen handelt.

Deshalb orientiert man sich am sogenannten Flußwechsel, d.h. an der Änderung der Polarität; der Lesekopf unterscheidet den Wechsel von nord- nach süd - magnetisiert.

Das Problem an diesen Flußwechseln ist, daß sie pro Quadratmillimeter begrenzt sind. Die Anzahl der Flußwechsel ist abhängig von der Beschaffenheit des magnetisierbaren Materials, der Flughöhe des Schreib-/Lesekopfes und seiner Empfindlichkeit.

Deshalb ringen die Herstellerfirmen um die verschiedenen Methoden um möglichst viele "Nullen und Einsen" auf einen Quadratmillimeter zu bekommen.

Hierzu gibt es verschiedene Methoden:

1. das FM - Verfahren

2. das MFM - Verfahren

3. das RLL - Verfahren

4. das PRML - Verfahren

Das FM - Verfahren (Frequenzmodulation: frequency modulation)

Dies ist die einfachste Kodiermethode.

Sie besteht aus einem einfachen Taktsignal (welches aus einem Flußwechsel besteht) und einem weiteren Flußwechsel. Taktsignal mit Flußwechel steht für eine "eins" und nur Taktsignal steht für eine "null".

Das MFM - Verfahren (Modifizierte Frequenzmodulation: modified frequency modulation)

Das MFM - Verfahren ist eine Modifikation des FM - Verfahrens. Es beendet die sinnlose Verschwendung der Flußwechsel. Der Takt wird nicht mehr mit Hilfe von diesen aufgezeichnet, sondern wird in der Elektronik mitgezählt. Er muß sich anhand der Flußwechsel orientieren. Ein Flußwechsel in einem Takt steht daher für eine "eins", kein Flußwechsel in einem Takt steht daher für eine "null". Wenn zu lange kein Flußwechsel kommt, droht das Taktsignal aus dem Tritt zu kommen. Daher macht man bei einer Doppelnull den Flußwechsel direkt auf der Taktflanke.

Wenn zu viele Nullen nebeneinanderstehen würden, entstünde ein zu großes Magnetfeld, welches die Flußwechsel verwaschen würde.

Mit der Codierung entsteht auch gleichzeitig eine Gleichstromfreiheit. Diese wird für die Synchronisierung der Elektronik und der besseren Datensicherheit benötigt.

Das RLL - Verfahren (Run Length Limited)

Das RLL - Verfahren ist ein Kodierverfahren, das noch mal 50% mehr Informationen auf die Platte bringt als das MFM - Verfahren. Das geschieht einfach dadurch, daß in einem Takt zwei bit gespeichert werden können. Dieses Verfahren setzt natürlich voraus, daß der Schreib- /Lesekopf noch mal sensibler ist, als der bei dem MFM - Verfahren.

Schon in den 80er Jahren lösten RLL-Codes das davor verwendete MFM-Verfahren ab

Das PRML - Verfahren (Partital Response Maximum Likelihood)

Das PRML - Verfahren wurde im Jahre 1990 von IBM entwickelt, und von Fujitsu 1993 erstmals in der Praxis verwirklicht.

Der PRML-Lesekanal (Partial Response Maximum Likelihood) löste das bisherige Peak-Detect-Verfahren ab und erlaubt die Benutzung eines Codes mit dichteren Flußwechseln. Statt stur die Impulse des Lesekopfes in Nullen und Einsen umzusetzen, basiert das PRML-Verfahren auf einem mathematischen Modell des Signals, mit dessen Hilfe ein Signalprozessor diejenigen Daten rekonstruiert, die mit größter Wahrscheinlichkeit zu dem gemessenen Lesesignal geführt haben. Ein PRML-Lesekanal ist sehr aufwendig und verbraucht durch die digitale Signalverarbeitung relativ viel Strom, erlaubt aber dafür die Verwendung effizienterer Codes und somit höhere Datendichten.

Datendichte einer Platte von 1994

Datendichte einer Platte von 1996

In zwei Jahren hat sich die Datendichte bei Festplatten verfünffacht. Magnetkraftmikroskopische Aufnahmen machen die Bits sichtbar und machen den Unterschied der Datendichten deutlich.

10. Partitionierung einer Festplatte

Eine Festplatte kann in mehrere Teile geteilt werden, die dann als mehrere Laufwerke angesprochen werden. So kann man z.B. mehrere Betriebsysteme installieren und Anfangs mit Hilfe eines Boot - Managers auswählen, welches System gebootet werden soll.

Eine Festplatte kann unterteilt werden in vier primäre Partitionen. Eine dieser Partitionen kann eine erweiterte Partition sein. Diese erweiterte Partition muß wiederum ein oder mehrere logische Laufwerke enthalten. Z.B.:

10 GB Platte: 2 GB Primäre Partition 2 GB Primäre Partition 4 GB Primäre Partition 2 GB erweiterte Partition beinhaltet: 1GB logisches Laufwerk 1GB logisches Laufwerk ----- 10 GB

Man hat nun insgesamt vier Primäre Partitionen, wobei eine der Partitionen eine erweiterte Partition ist, die zwei Logische Laufwerke beinhaltet.

Am Anfang der Festplatte steht der Master Boot Record. In ihm ist die Partitionstabelle enthalten, die die genauen Daten über Größe und Anzahl der verschiedenen Partitionen angibt.

Jede Partition enthält einen Bootsektor.

Es kann normalerweise nur von der Partition gebootet werden, die ein aktive Flag besitzt.

Die Partitionen werden von äußen nach innen der Platte angelegt. Bei bestimmten Betriebsystemen wie z.B. Linux, sollte darauf geachtet werden, daß die Swap - Partition als erste erstellt wird, um in dem schnellsten Bereich der Platte zu liegen.

11. Abkürzungen

| AIT | Advanced Intelligent Tape |

| ASIC | Application Specific Integreated Circuit |

| AT-Bus | IDE Bus |

| ATA | AT Attachment |

| ATAPI | AT Attachment Packet Interface (Bez. für EIDE CDROMs) |

| BPI | Bits per Inch |

| CHS | Cylinder-Head-Sector |

| CS | Cable Select |

| DC | Data Cartridge |

| DD | Double Density (3.5": 720 kB; 5.25": 320 kB) |

| DDS | Digital Data Storage |

| DLT | Digital Linear Tape |

| DMA | Direct Memory Access |

| ED | Extra Density (3.5": 2.88 MB) |

| EIDE | Enhanced IDE (auch: Fast ATA-2) |

| EPA | Environmental Protection Agency (amerik. Umweltbehörde) |

| EPRML | Enhanced PRML |

| Fast-ATA | Seagate Standard (Fast-ATA ist eine Untermenge von EIDE) |

| FAT | File Allocation Table (DOS Dateisystem, Dateizuordnungstabelle) |

| FDD | FloppyDisk Drive (Diskettenlaufwerk) |

| FH | Full height |

| HD | High Density (3.5": 1.44 MB; 5.25": 1.2 MB) |

| HDD | HardDisk Drive (Festplatte) |

| HH | Half height (1") |

| HPFS | High Performance File System (Dateisystem von OS/2) |

| I/O | Input/Output |

| ID | Identification(-Number) |

| IDE | Integreated/Intelligent Drive Electronics |

| LBA | Logical Block Addressing |

| LIMDOW | Light Intensity Modulation - Direct OverWrite |

| LL | Low Level (Format) |

| LUN | Logical Unit Number (SCSI 'Sub-ID') |

| MA | Master |

| MFM | Modified Frequency Modulation (alter Festplattenstandard) |

| MR | Magneto-resistiv (spez. Technik für HDD Leseköpfe) |

| ms | Millisekunde (10-3 s) |

| MTBF | Mean Time Between Failure (Mittlere Zeit bis zum Defekt) |

| ns | Nanosekunde (10-9 s) |

| NTFS | New Technology File System (Dateisystem von Windows NT) |

| PCI | Peripheral Component Interconnect (schnelles Bussystem) |

| PD | Peak Detection |

| PFA | Predictive Failure Analysis (TM) |

| PIO | Programmed I/O (z.B. (E)IDE Transfer läuft über PIO) |

| PRML | Partital Response Maximum Likelihood (HDD Lesetechnik) |

| RAID | Redundant Array of Inexpensive Disks |

| RLL | Run Length Limited (alter Festplattenstandard) |

| rpm | rotations per minute (Umdrehungen pro Minute) |

| SASI | Shugart Associates System Interface |

| SCAM | SCSI Configures Automatically ('Plug and Play SCSI') |

| SCSI | Small Computer Systems Interface |

| SDMS | SCSI Device Management System |

| SL | Slave |

| SMART | Self Monitoring, Analysis and Reporting Technology |

| SPT | Sectors per track (Sektoren pro Spur) |

| VFAT | Virtual FAT (FAT Erweiterung, in WfW 3.11 und Win 95) |

| XCHS | Extended Cylinder-Head-Sector |

| ZBR | Zone Bit Recording |

| Zoll | 1 Zoll = 2.54 cm |

12. Quellenangabe

Bücher:

- PC - Werkstatt von Klaus Dembrowski

ISBN 3-8272-5310-1

Kapitel: 3.1.1

- PC Aufrüsten und Reparieren

2. erweiterte Auflage 1990

Internet:

- http://www.ibm.com

- http://www.storage.ibm.com

- http://www.almaden.ibm.com

- http://www.research.ibm.com

- http://www.domino.watson.ibm.com

- http://www.megabyte.com

- http://www.zdnet.com

- http://www.empl.ibm.com

- http://www.haffapartner.de

- http://www.maxtor.com

- http://www.seagate.com

- http://www.wdc.com

|

|